爬虫代理是什么

在当今信息爆炸的时代,网络上的数据量巨大且不断增长。为了从这些海量数据中提取有价值的信息,爬虫成为了一种重要的工具。然而,许多网站对爬虫进行了限制,封禁IP地址或频繁访问的用户。为了绕过这些限制,使用爬虫代理就变得必要。p

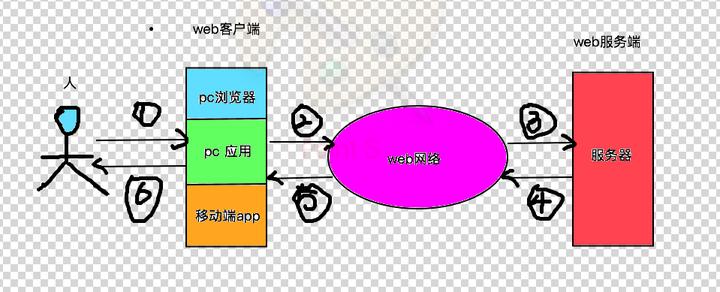

爬虫代理是一种中间人服务器,它充当用户与目标网站之间的桥梁。代理服务器会将用户的请求转发给目标网站,并将目标网站的响应返回给用户。通过使用代理服务器,用户的真实IP地址得以隐藏,这有助于绕过一些网站对频繁访问或非法爬取的限制。p

爬虫代理的使用技巧和注意事项

1. 选择可靠的代理提供商

市场上有许多提供爬虫代理服务的公司和个人,但并非所有都是可靠的。在选择代理提供商时,要考虑以下几个因素:

– 速度和稳定性:代理服务器的速度和稳定性对爬虫的运行效果至关重要。确保代理服务器具有足够的带宽和稳定的连接。p

– 地理位置:根据爬取的目标网站的地理位置选择代理服务器,这有助于提高访问速度和成功率。

– 代理类型:代理服务器可以分为两种类型,分别是共享代理和专用代理。共享代理多个用户共享同一个IP地址,而专用代理则为每个用户分配独立的IP地址。根据不同的需求选择合适的代理类型。

2. 设置请求头信息

在使用爬虫代理时,要设置请求头信息,模拟真实用户的行为。包括User-Agent、Referer等头信息,这样可以提高爬虫的隐蔽性,减少被网站封禁的风险。

3. 合理控制爬取速度

不同的网站对爬虫的访问频率有不同的限制。如果请求过于频繁,可能会导致IP地址被封禁,甚至影响正常用户的访问。因此,合理控制爬取速度是非常重要的。可以设置合适的访问间隔或通过使用代理轮换来降低被封禁的风险。

4. 遵守网站的规则

虽然使用爬虫代理可以绕过一些限制,但我们仍然需要遵守网站的规则和政策。不要进行非法爬取、恶意刷取等行为,遵循网站的robots.txt文件和条款。

总结

爬虫代理是一种绕过网站限制的重要工具,它可以保护用户的隐私并提高爬虫的效果。在使用爬虫代理时,我们需要选择可靠的代理提供商、设置合适的请求头信息、合理控制爬取速度,并遵守网站的规则。只有遵循这些技巧和注意事项,我们才能更好地利用爬虫代理进行数据采集和信息提取。

暂无评论内容